الگوریتمهای استخدام: وقتی ماشینها هم اشتباه میکنند

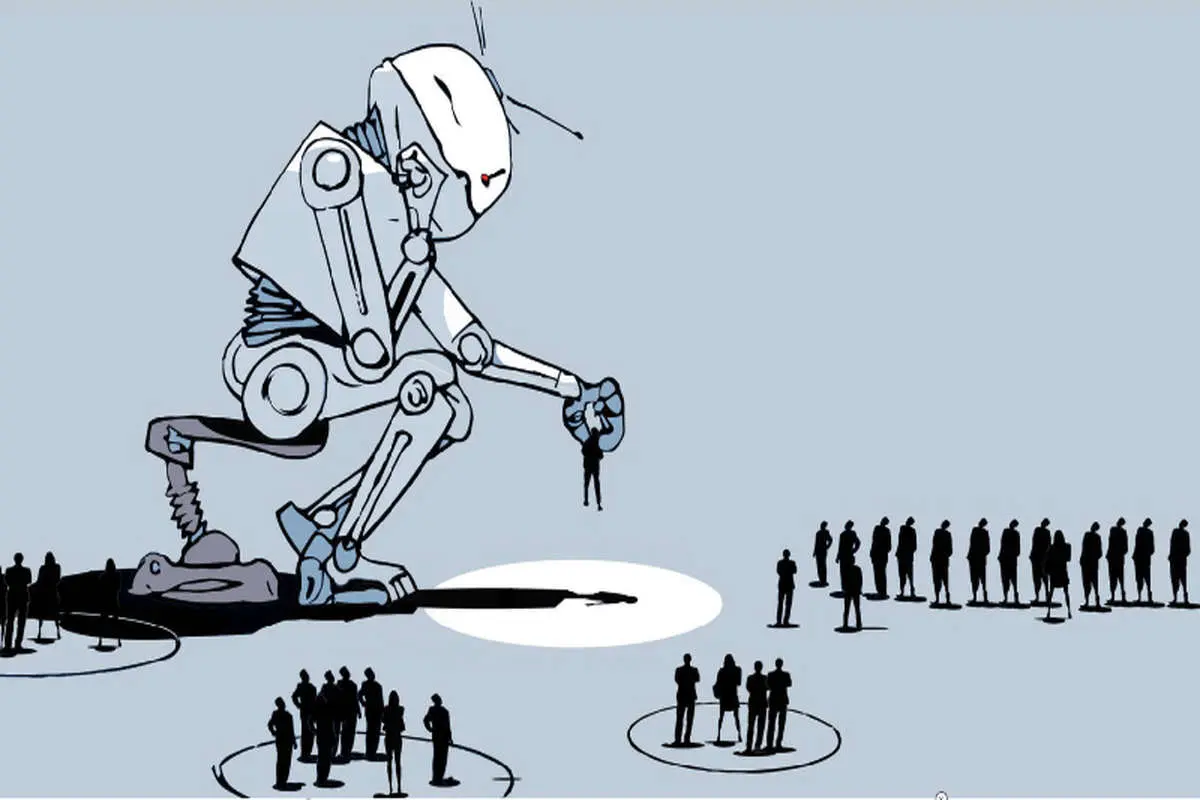

آیا الگوریتمهای استخدام از سوگیری جلوگیری میکنند یا باعث تقویت آن میشوند؟ این سوال بنیادین کشمکشی بین طرفداران و مخالفان فناوری است، اما دست یافتن به جواب پیچیدهتر از چیزی است که به نظر میرسد. استخدام بهندرت یک تصمیم واحد و مجزا است، بلکه مجموعهای از تصمیمات پیدرپی کوچکتر است. الگوریتمها نقشهای متفاوتی در این

آیا الگوریتمهای استخدام از سوگیری جلوگیری میکنند یا باعث تقویت آن میشوند؟ این سوال بنیادین کشمکشی بین طرفداران و مخالفان فناوری است، اما دست یافتن به جواب پیچیدهتر از چیزی است که به نظر میرسد.

استخدام بهندرت یک تصمیم واحد و مجزا است، بلکه مجموعهای از تصمیمات پیدرپی کوچکتر است. الگوریتمها نقشهای متفاوتی در این فرآیند بازی میکنند: بعضی آگهیهای شغلی متقاضیان خاصی را شامل میشوند، در حالی که سایر آگهیها متقاضیان بالقوه را در برمیگیرند. ابزارهای پیشبینیگر رزومهها را بررسی و طبقهبندی میکنند و به مدیران استخدام کمک میکنند با استفاده از دادههای سنتی و نوین و با روشهای جدید، صلاحیت متقاضیان را ارزیابی کنند.

امید میرود که الگوریتمها در تصمیمات استخدامی با افزودن ثبات به فرآیند استخدام جلوی تعصبات را بگیرند. اما الگوریتمها خطرات و ریسکهای خودشان را دارند. آنها میتوانند باعث تکرار شدن سوگیریهای سازمانی و تاریخی شوند و همچنین نقاط ضعف دادهها مانند حضور در دانشگاه یا امتیازات ارزیابی عملکرد را تقویت کنند. حتی اگر الگوریتمها بعضی موانع را از فرآیند استخدام حذف کنند، هنوز هم انسانها بخش مهمی از تصمیمات استخدام هستند. استدلالهایی که الگوریتمهای عینی را عادلانهتر و دقیقتر از انسانهای جایزالخطا میدانند، این مورد را در نظر نمیگیرند که در بیشتر موارد الگوریتمها و انسانها یک نقش را بازی میکنند.

استخدام بهندرت یک تصمیم واحد و مجزا است، بلکه مجموعهای از تصمیمات کوچکتر متناوب است.

درک سوگیری در الگوریتمهای استخدام و راههای کاهش آن، ما را ملزم میکند تا بفهمیم که فناوری پیشبینیگر در هر مرحله از فرآیند استخدام چگونه عمل میکند. اگرچه الگوریتمها بر اساس یادگیری ماشینی ایجاد شدهاند، ابزارهایی که در مراحل اولیه مورد استفاده قرار میگیرند میتوانند از نظر بنیادی متفاوتتر از ابزارهای مراحل بعدی باشند. حتی ابزارهایی که به نظر میرسد برای یک وظیفه یکسان استفاده شوند هم ممکن است به انواع دادههای مختلف متکی باشند یا پیشبینیهایی را به روشهای مختلف ارائه دهند.

ایجاد مخزن متقاضی

فرآیند استخدام قبل از آنکه یک کارجو رزومهاش را ارسال کند، آغاز میشود. در مرحله جذب یا استخدام، فناوریهای پیشبینیگر به آغاز انتشار آگهیهای استخدام کمک میکنند، کارجویان را نسبت به موقعیتهای شغلی قابل درخواست آگاه میکنند و متقاضیان آینده را برای دستیابی به اهداف به استخدامکنندگان معرفی میکنند.

برای جذب متقاضیان، بسیاری از کارفرماها از پلتفرمها و آگهیهای شغلی تبلیغاتی الگوریتمی برای شناسایی مرتبطترین کارجو استفاده میکنند. این سیستمها، که به کارفرمایان وعده استفاده موثرتر از بودجههای استخدامی را میدهند، اغلب پیشبینیهای بسیار سطحی دارند: آنها پیشبینی نمیکنند که چه کسی میتواند در این شغل موفق باشد، بلکه اغلب افرادی را که بیشتر روی آگهیهای استخدامی کلیک میکنند، شناسایی میکنند.

این پیشبینیها میتواند منجر به شکلگیری کلیشههای جنسیتی و نژادی در آگهیهای شغلی شود، حتی وقتی که استخدامکنندگان چنین قصدی نداشته باشند. در جدیدترین تحقیقی که در دانشگاه USC انجام شده، محققان دریافتهاند که تبلیغات هدفمند در فیسبوک برای شغل صندوقدار فروشگاه برای ۸۵٪ از زنان به نمایش درآمده، در حالی که حدود ۷۵٪ از مخاطبان آگهیهای شغلی مربوط به شرکتهای تاکسیرانی، مردان سیاهپوست بودهاند. این مثالی از بازتولید سوگیری در الگوریتم از دنیای واقعی و بدون دخالت نیروی انسانی است.

در ضمن، آگهیهای شغلی شخصیسازیشده در نظر دارند تا ترجیحات استخدامکنندگان را بهطور خودکار یاد بگیرند و از پیشبینیها برای جذب متقاضیان مشابه استفاده کنند. مانند فیسبوک، چنین سیستمهای پیشنهادی برای یافتن و تکثیر الگوهای رفتاری کاربر ساخته شدهاند و بهصورت پویا و با استفاده از تعامل کارفرما و کارجو بهروزرسانی میشود.

اگر سیستمها متوجه شوند که کارفرمایان بیشتر با مردان سفیدپوست تعامل دارند، میتواند منجر به ایجاد فیلترهایی بر اساس آن ویژگیها شود (مانند اسم کیوان و اینکه در دانشگاه بدمینتون بازی میکرده) و این الگوها را تکثیر کنند. این گونه از تاثیرات منفی میتواند بدون دستورالعمل واضح و روشن، بدتر از آن، بدون اینکه کسی متوجه شود، اتفاق بیفتد.

افراد وقتی که به «الگوریتمهای استخدام» فکر میکنند، به الگوریتمهای منابع چندان توجه نمیکنند، اما تصمیمات خودکار در مراحل اولیه قیف استخدام رایج است. برای مثال، ابزاری که آمازون برای زنان ساخت، ابزاری برای ارزیابی متقاضیان واقعی نیست، اما ابزاری است که به کشف متقاضیان بالقوه برای استخدام توسط کارفرمایان کمک میکند.

الگوریتمهای منابع شاید متقاضیان را رد نکنند، اما مطلع نکردن افراد از یک موقعیت شغلی، خود مانع موثر بزرگتری برای کارجویان است. این ابزار نقش مهمی در تعیین دسترسی به به فرآیند استخدام ایفا میکنند.

باریکسازی قیف

هنگامی که درخواستهای شغلی به سمت شرکت سرازیر میشوند، کارفرمایان روی پیدا کردن قویترین متقاضیان تمرکز میکنند. در حالی که الگوریتمهای استفادهشده در این مراحل اغلب به عنوان دستیاران مدیران استخدام شناخته میشوند، در واقع، آنها میتوانند بهطور خودکار بخش قابل توجهی از متقاضیان را رد کنند.

بعضی از این الگوریتمهای غربالگری، روشهای قدیمی هستند که با فناوری جدید طراحی شدهاند. کارفرمایان مدتهاست که برای فهمیدن حداقل میزان مهارت کارجویان از «سوالهای حذفی» استفاده میکنند. امروزه، رباتهای گفتگو و ابزارهای بررسی رزومه این وظیفه را به عهده دارند. دیگر ابزارها پا را فراتر گذاشتهاند و از یادگیری ماشینی برای پیشبینی بر اساس تصمیمهای غربالگری قبلی استفاده میکنند، در وقت کارفرمایان صرفهجویی میکنند و تاثیر تعصبات انسانی را کاهش میدهند. در نگاه اول، شاید مدلسازی تصمیمات استخدامی قبلی در ابزارهای غربالگری عادی به نظر برسد، این تصمیمات معمولا بازتاب الگوهایی هستند که کارفرمایان تنوع و نوآوری تغییر دهند.

دیگر ابزارهای گزینش دربرگیرنده یادگیری ماشینی برای پیشبینی متقاضیان موفق در شغل هستند که اغلب توسط نشانههای مرتبط با علاقه، خلاقیت و یا عملکرد سنجیده میشوند (یا با عدم وجود نشانههایی مانند کمکاری یا اقدامات انضباطی). ابزارهای جدیدتر در این فضا ادعا میکنند که به کارفرمایان کمک میکنند تا با استفاده از نشانههای دقیق پیشبینیهای خود را انجام دهند، مانند بازی یا تحلیل ویدیویی.

قابل ذکر است که در ایالات متحده این روشهای گزینش در چارچوب مقررات سنتی انجام میشود. کارفرمایان موظفند ابزارهای ارزیابی خود را نسبت به تاثیر منفی بر زیرگروههای جمعیتی کنترل کنند، که این ابزارها میتوانند از رویههایی به نفع گروههای خاصی از متقاضیان استفاده کنند. بسیاری از ارائهدهندگان ابزارهای ارزشیابی، مراحلی را که برای «عدم تعصب» در الگوریتمهایشان طی کردهاند، شرح میدهند، مراحلی برای اطمینان از اینکه مشتریانشان بر اساس قانون عمل میکنند.

اما کنش واقعی فرق قائل شدن بین متقاضیان ردهبالا با متقاضیان ردهپایین اغلب بازتاب ارزیابیهای ذهنی است، که منشا آشکار تبعیض در محیطهای کاری است. اگر دادههای اصلی عملکرد تحت تاثیرات طولانیمدت جنسیتگرایی، نژادپرستی یا دیگر سوگیریهای ساختاری قرار بگیرند و آلوده شوند، عدم تعصب در یک الگوریتم استخدام که بر اساس آن دادهها تهیه شده، فقط یک باند و پوشش روی آن زخم عفونی است و اگر یک کارفرما بتواند ثابت کند که آن ابزار گزینش در خدمت منافع خاص تجاری است، آنها میتوانند بهراحتی و با استفاده از یک الگوریتم گزینش که منجر به نتایج ناعادلانه میشود، آن را توجیه کنند.

وقتی که یک کارفرما یک متقاضی را برای استخدام انتخاب میکند، سایر ابزارهای پیشبینیگر برای کمک به کارفرما به دنبال متقاضی دیگری که شاید مورد تایید واقع شود، میگردند.

برخی روانشناسان صنعتی سازمانی، که اغلب درگیر بهبود رویههای استخدام هستند، به همبستگیهای تئوریک به عنوان پایهای برای ابزارهای جدید گزینش متکی هستند. اما در دستورالعملهای کنونی لازم نیست کارفرمایان کار بیشتری انجام دهند.

در نهایت، وقتی که یک کارفرما یک متقاضی را برای استخدام انتخاب میکند، سایر ابزارهای پیشبینیگر برای کمک به کارفرما به دنبال متقاضی دیگری که شاید مورد تایید واقع شود، میگردند. چنین ابزارهایی میتوانند قوانینی را برای کارفرمایان در جهت ممنوعیت پرسیدن سوالاتی درباره حقوق و دستمزد تعیین کنند

ایجاد تمایل در الگوریتمهای استخدام به سمت برابری

در حالی که قانون ایالات متحده محدودیتهایی را برای کافرمایان در مورد استفاده از ابزارهای پیشبینیگر استخدام تعیین میکند، اما برای شناسایی خطرات معرفیشده توسط ابزارهای استخدامی یادگیری ماشینی کارایی ندارد.

پس چطور میتوانیم مطمئن باشیم که الگوریتمهای استخدام منجر به برابری میشوند؟ بهترین قوانین و کارکردهای صنعت نقش قابل توجهی در این زمینه دارند. در عین حال، فروشندگان ابزارهای پیشبینیگر استخدام و کارفرمایان استفادهکننده از این ابزارها باید درباره مواردی بیشتر از حداقل الزامات سازگاری فکر کنند. آنها باید به وضوح این موضوع را در نظر داشته باشند که الگوریتمهایشان منجر به نتایج استخدام عادلانهتری شود.

قبل از استفاده از هر گونه ابزار پیشبینیگر، آنها باید ارزیابی کنند که چگونه معیارهای ذهنی موفقیت میتواند به مرور زمان پیشبینیهای یک ابزار را شکل دهد و علاوه بر بررسی تاثیر زیانبار در مرحله گزینش، کارفرمایان باید خطوط کاریشان را از آغاز تا انتها برای کشف بخشهایی که سوگیری نهفته دارد یا در حال ایجاد سوگیریهای جدید است، تحت نظارت داشته باشند.

چنانچه آنهایی که از پتانسیل الگوریتمها برای کاهش سوگیری در استخدام استفاده میکنند، تصمیم بگیرند که برای پیشگیری از سوگیری ابزارهای خود را با هدفی که در ذهن دارند، بسازند و آزمایش کنند، فناوری در بهترین حالت در جهت تحقق کاهش سوگیری عمل میکند و در بدترین حالت، آن را تضعیف میکند.

نویسنده: میراندا بوگن (Miranda Bogen)

مترجم: میلاد قزللو

عنوان اصلی مقاله: All the Ways Hiring Algorithms Can Introduce Bias

نشریه: Harvard Business Review

میلاد قزللو

میلاد قزللو

نظرات